Аб тестирование. AB test: как его проводить и что для этого нужно

Сергей Гудков , специалист по разработке и продвижению сайтов (более 160 сайтов и 250 сплит-тестов), руководитель Сonversion42

Андрей Осипов , сертифицированный тренер Google, практикующий веб-аналитик, автор блога «Веб-аналитика и результат»

Мы часто получаем запросы на тексты для А/В-тестирования. Для каких целей есть смысл его проводить?

А/В-тест можно проводить практически для любых изменений на сайте. Ведь тест – это возможность достоверно узнать, насколько они эффективны.

Если у вас страница с описанием услуги, то основной продающий контент – это именно текст. Посетители на основании текста принимают решение оставить заявку или нет. В данном случае текст является основным объектом тестирования:

- какие характеристики указывать в тексте, а какие нет;

- какие призывы использовать в тексте;

- в каком стиле должен быть написан текст и т.д.

Запрос «текст для А/В-тестирования» звучит не очень. Лучше заказывать просто новый, более продающий текст. А измерять продающие характеристики текста можно с помощью тестирования.

A/B-тестирование для сайтов: нужно тестировать текст, дизайн, страницу в целом, «продающесть» текста или страницы?

Тестировать можно что угодно.

Если вы думаете, что кнопка «Купить» незаметна, тестируйте только изменение кнопки. Если вы сделали новый дизайн страницы, можно протестировать разницу между двумя дизайнами.

Иногда в тесте сравнивают два сайта. Это очень спорное занятие – если вам интересно, предлагаем обсудить этот вопрос на вебинаре более конкретно.

Можно тестировать и по одному элементу за раз, и сразу целые страницы. От чего это зависит? Всё очень просто. Если у вас есть 10/30/100 мелких изменений, и вы уверены, что каждое из них увеличит конверсию, совмещайте это всё в один тест. Если запускать их по отдельности, то делать даже 30 тестов – это может быть очень долго и не слишком эффективно. И наоборот. Если есть одно важное изменение, и вы сомневаетесь насчет реакции посетителей сайта на него, запускайте один тест на одно изменение.

Какие данные (максимум) можно получить при А/В-тестировании?

Смысл А/В-тестов крайне прост: делим посетителей на две группы – одной из них показываем вариант А, другой – вариант В.

Основным результатом теста считается разница между поведением пользователей. Например, мы хотим узнать, как изменится конверсия интернет-магазина.

Также при интеграции А/В-теста с системами веб-аналитики, в частности с Google Analytics, можно увидеть разницу в поведении по всем параметрам: глубина и время посещения, посещение конкретных страниц, показатели отказов, достижение всех целей и т.д.

Какие сервисы могут помочь правильно провести A/B-тест?

Правильность запуска всегда зависит от вас. Сервисы – это инструмент. Как молоток. Если вы умеете им пользоваться, то у вас всё получится. ☺

Самые распространённые сервисы для запуска А/В-тестов:

- Google Analytics (бесплатный);

- VWO (платный, https://vwo.com/ );

- Optimizely (платный, https://www.optimizely.com/ ).

Для большинства потребностей хватает Google Analytics. Мы сами его часто используем и вам рекомендуем.

Сколько элементов можно тестировать за один раз? Правильно ли сравнивать 2 текста, в которых отличается более 1–2 элементов?

Да, можно. Самое главное, нужно понимать, как эти элементы повлияют на конверсию и почему. У вас должна быть рабочая гипотеза.

Когда вы проводите очень-очень много тестов, бывают моменты, когда идей и гипотез нет. Такой себе провал. В такие моменты можно тестировать по принципу «А давайте сделаем и поглядим… Интересно же». ☺

В А/В-тестировании самое ценное – это время и объем трафика. Иными словами, вы можете провести ограниченное количество тестов в ограниченное время. Поэтому простой сайта без теста – это растрата бесценного ресурса.

Какие условия должны соблюдаться для правильного А/В-тестирования? Какой минимум просмотров/визитов/уников?

Чтобы тест получился хорошим, должно соблюдаться достаточно много условий. Назовем основные из них:

- Должен быть целевой показатель, например, общая конверсия интернет-магазина или лендинга, показатель отказов какой-то группы страниц, кликабельность кнопки «Купить» и т.д.

- Тест должен завершиться победой одного из вариантов со статистической достоверностью. Это означает, что данный вариант с очень большой вероятностью действительно лучше.

- Тест должен продолжаться ~2 цикла принятия решения о покупке. Например, известно, что девушки выбирают украшения около недели. Значит, минимальный срок теста составит 2 недели. В целом мы рекомендуем держать тесты от 1 до 3 недель.

Вопрос «А сколько надо трафика?» не совсем корректный. Длительность теста зависит от количества трафика и дельты целевого показателя. Например, тест с увеличением конверсии с 1% до 2% завершится быстрее, чем тест, где рост будет с 1% до 1,2%. Также тест на сайте с посещаемостью 1000 человек в сутки будет идти дольше, чем на сайте с 5000 посетителей.

Как интерпретировать полученные результаты для дальнейшей проверки гипотез?

Интерпретация результатов довольно проста. Выигравший вариант надо внедрить. ☺

В любом случае, независимо от результатов теста, вы обязаны оценить поведение людей на новом варианте. Это даст вам новые идеи для новых гипотез.

Какие главные ошибки допускаются при А/В-тестировании?

Ошибок много. ТОП-3 из них:

- Тесты заканчивают раньше достижения статистической достоверности. Это может очень дорого стоить бизнесу. Внедряя изменения после таких тестов, вы не знаете, сделали вы лучше или хуже.

- Тестируются необоснованные идеи, подсказанные уборщицей из соседнего офиса. По сути, впустую тратятся бесценное время сайта и ресурсы компании на подготовку и реализацию теста.

- Не отслеживаются показатели во время теста. Часто бывает, что при запуске программисты ошиблись, и одна вариация работает с ошибкой. Если не контролировать тест, то узнать об этом можно через недели 2–3. Это пустая трата времени и ресурсов.

AB test, полезная штука, которая просто должна быть по-умолчанию в интернет проектах. Как проводить и что для этого нужно?

Сегодня тестирование гипотез и проверка идей, обязательная программа. Под эту задачу отлично подходит AB test. Давайте разберём подробнее, что это вообще такое, в чём польза и какие есть инструменты.

AB test: что это и зачем

AB test или Split test - метод маркетингового исследования, суть которого заключается в том, что вы берёте и сравниваете несколько вариантов элемента продукта с одним определенным изменением. А после смотрите какой из вариантов показал себя лучше.

К примеру, у нас родилась идея, поменять цвет кнопки на некой странице. Мы думаем, что это изменение принесёт нам больше кликов. Запускаем оба варианта, половине наших пользователей показываем вариант A, а другой половине вариант B.

По прошествии какого-то времени (продолжительность определяется перед запуском теста) замеряем результат. Смотрим какой из вариантов лучше отработал и используем его в работе. Таким образом вы можете проверять практически любые гипотезы и смотреть, что лучше работает, а что нет.

Что можно анализировать с помощью AB test?

- Конверсии. Кол-во успешных целевых действий на вашем сайте. Это может быть нажатие на кнопку “Купить”, посещение какой-то страницы или что-то ещё.

- Экономика. Средний чек или объём выручки.

- Поведенческие факторы. Глубина просмотра, длительность сеанса.

Нюансы и тонкости

- Очень важно при тестировании менять только один фактор. Если это цвет кнопки на лендинге, то мы тестируем только разные цвета кнопок и не меняем больше ничего на страницах.

- Также и с внешними факторами. Тест запускается в одно и то же время при одних и тех же условиях. В противном случае вы можете получить данные, которые будут необъективными.

Простите, что прерываю чтение. Присоединяйтесь к моему telegram канал . Свежие анонсы статей, развитие digital продуктов и growth hack, там все. Жду вас! Продолжаем…

Важно про данные

Всё было бы очень просто, если бы не одно “Но”. Можно провести AB test, получить результаты, где откровенно видно, что один из вариантов сильно лучше другого.

Например, мы показали 2 варианта страниц с разным цветом кнопок по 1000 раз каждый. Проводили тест одну неделю. И получили следующие результаты:

При одинаковых показах баннера (это важно), кол-во кликов у варианта B больше в три раза. Делаем вывод, что этот вариант более эффективный и берём его в рабочую версию, а старый удаляем.

А если, к примеру, так?

Стоит ли брать вариант B? Или может быть это просто погрешность? Да и достаточно ли показать 1000 раз каждый из вариантов, чтобы принять решение? Может к нам на сайт в день заходит 10 000 пользователей и выборка очень мала, чтобы сделать вывод? А если, данные которые мы анализируем, не просто кол-во кликов, а средний чек с транзакций?

Статистика нам в помощь

Чтобы понять, как устроен мир цифр и экспериментов, давайте немного разберём мат.часть. Если нет времени и сил, то советую пропустить этот раздел. Дальше, я дам более простые решения задачи.

Большой соблазн, когда получили результаты эксперимента, принять решение и всё, вот оно, “светлое будущее”. Но, ведь, если копнуть немножечко глубже, то за неделю распределение кликов по дням было неравномерным. Давайте распишем.

В таблице видно, что клики по дням распределены по-разному. А значит, наши значения варианта A и варианта B могут меняться каждый день. То есть, мы имеем дело со случайными величинами. Для таких случаев применяют средние значения. Но ведь, если мы проведем эксперимент ещё раз, то какова вероятность, что результат повториться?

Изобразим на графике распределение всех данных за неделю по варианту A и B.

Если мы возьмём средние величины по каждому из вариантов (это вертикальные полоски посередине двух волн), то увидим, что разница совсем невелика. Но существуют определенные отклонения, в большую и меньшую сторону от среднего. Поэтому, мы получаем пересечение двух волн. Чем оно больше, тем меньше значимость эксперимента и, соответственно, чем меньше пересечение, тем выше статистическая значимость.

Статистическая значимость, это то, насколько верны полученные результаты. То есть в нашем примере, ответ на вопрос “нужно ли брать вариант B?”.

Обычно, по-умолчанию принимают уровень значимости равный 95%. Это означает, что мы с 95% вероятностью хотим знать, стоит ли выбирать другой вариант (B) при сравнении. Оставшиеся 5%, это вероятность ошибки, которую мы допускаем или p-value в терминологии статистики.

Интересно, что многие забывают проверять уровень значимости в своих экспериментах и тем самым могут получать ошибочные данные. 8 из 10 AB тестов проходят мимо этой оценки. ( )

Не буду вдаваться долго в подробности, как рассчитывается показатель значимости, просто дам инструмент, который посчитает все за вас.

Инструменты для расчета значимости

Для оценки значимости данных советую использовать этот инструмент .

Здесь у нас A и B соответственно наши варианты. А по цифрам:

- Число посетителей/можно кол-во показов вставлять.

- Кол-во конверсий. Нажали на кнопку, зарегистрировались. В общем выполнили целевое действие.

- P-value. Вероятность ошибки, которую мы опускаем при заданных данных.

- Ответ на вопрос существенны ли, полученные изменения в нашем эксперименте.

Пример: берём данные по показам и кликам из таблицы, которую показывал выше.

Забиваем их в сервис, нажимаем на кнопку “Calculate Significance” и…

Получаем ответ “No” или “Нет” (по-русски) в нижней строке, а чуть выше p-value 0,283. Что это означает? А то, что с вероятностью 28,3% (0,283*100), если мы выберем вариант “B”, то он не принесёт никаких существенных результатов.

Чтобы эксперимент считался успешным, p-value должен быть меньше 5%

Есть ещё один сервис, в который также вбиваете данные и смотрите результат, доступен по ссылке .

На этом строится базовый принцип измерения случайных величин. Просто в тот момент, когда получите результаты AB test, прогоните их через инструмент и посмотрите, а на столько лишь значимо улучшение от другого варианта, чтобы брать его в работу?

Как понять сколько нужно данных?

Бывает так, что для получения выводов недостаточно полученных данных.Для того, чтобы понять, сколько раз нужно показать страницу A и B, а затем получить нужное кол-во данных, используйте этот инструмент .

Очень важно, повторюсь, запускать эксперимент при одних и тех же условиях. В идеале мы берём неделю, на которой нет ни праздников, ничего остального и параллельно тестируем варианты. Вернёмся к сервису.

Благодаря этому сервису вы поймете размер выборки для каждого из вариантов.

Подробнее по пунктам:

- Существующий уровень конверсии. Или, например, сколько процентов из всех пользователей сейчас нажимают кнопку.

- Минимально значимое изменение, которое нас интересует. На сколько мы хотели бы изменить базовый показатель конверсии.

- Значимое отклонение, которое мы ввели на предыдущем шаге показывает, что конверсия может увеличится, так и уменьшиться.

- Вы выбираете значение: absolute (абсолютный) или relative (относительный). Выбирайте то значение, которое хотите получить. Если у вас baseline уровень конверсий равен 30% (как в примере с картинки) и вы хотите повысить его на 5% с помощью ab тестов, то выбирайте “relative”. То есть, финальный результат изменения в случае успешности эксперимента будет 5% от 30%, то есть 31,5%.

- Размер выборки для каждого варианта. Сколько мы должны раз показать страницу отдельно A и страницу B, чтобы сделать выводы по эксперименту. Очень важно! Чтобы сделать выводы по эксперименту, мы показываем 24 409 раз A и 24 409 раз B!

- Статистическая значимость. На сколько точный эксперимент мы хотим провести.

- Погрешность p-value. Какую вероятность ошибки допускаем.

Можно ли останавливать эксперимент раньше?

Можно. Существует вариант, когда мы можем не дожидаться окончания эксперимента, а на определенном этапе уже сделать выводы. Для этого используйте уже известный инструмент, вкладка “ Sequental Sampling “.

По шагам:

- Вбиваете свой уровень конверсии сейчас. К примеру 30%, именно столько из 100% заходящих к нам на страницу нажимает кнопку.

- Набираете, на сколько вы хотели бы повысить ранее введенный показатель. Поставил на 10%. Было 30, хочу до 33 поднять.

- Кол-во конверсий одного из экспериментов, после которого останавливаем эксперимент и принимаем решение.

- Разница в конверсиях между вариантом A и B, после которой останавливаем эксперимент и берем, тот, что больше набрал.

- Выставляем уровень значимости 95% (как положено, см.выше материал).

- Устанавливаем погрешность p-value (опять же, см.выше материал).

Здесь нет никакой хитрости, просто статистика. Используйте этот инструмент, когда эксперименты занимают много ресурсов (время на разработку, бюджеты на рекламу для проверки гипотез и т.д.). Теперь у вас есть два правила, при которых вы можете останавливать эксперимент и делать выводы.

Чем проводить AB test?

Готовые решения:

- Optimizely, vwo.com, zarget.com

- http://alternativeto.net/software/optimizely

- Google Analytics (ссылка как проводить)

Собственное решение:

- Пишем админку.

- Пишем и настраиваем каждый эксперимент.

Вот про 10 сервисов для AB test. Есть из чего выбрать.

Всё

Теперь у вас есть общее представление, что такое AB test, какие существуют нюансы и какими инструментами его проводить. В заключение добавлю что данное исследование гипотез является одним из самых полезных в развитии digital проекта. Разве не прекрасно, что можно проверить практически любую идею? Главное правильно, теперь вы знаете как.

Оригинальная публикация:

http://quality-lab.ru/a-b-testing/

Введение

Эмоции управляют людьми, а управление эмоциями людей – мечта каждого маркетолога. Как правило, все нововведения основаны на субъективном «мне кажется, что так будет красивее/удобнее». Гораздо реже под конкретное изменение проводится анализ мнения клиентов. Надеяться на субъективную оценку маркетолога можно, но рискованно. Собирать фокус-группу – затратно. Просто ввести изменение и посмотреть, что же произойдет по прошествии определенного времени, – не научно.

Так как же все-таки определить пользу изменений без потери клиентов и времени? Этот вопрос решает A/B тестирование. Его использование ведет к увеличению трафика клиентов и степени конверсии сайта, к росту количества продаж, кликов и лайков.

Что это такое?

Определение из Wiki:

A/B-тестирование

(англ. A/B testing, Split testing) – метод маркетингового исследования. Суть метода заключается в том, что контрольная группа элементов сравнивается с набором тестовых групп (в которых один или несколько показателей были изменены) для того, чтобы выяснить, какие из изменений улучшают целевой показатель. Разновидностью A/B-тестирования является многовариантное тестирование.

В этом случае тестируются не два целостных варианта, а сразу несколько элементов продукта или составных частей исследуемого объекта в различных сочетаниях, при которых каждый тестируемый элемент может быть двух видов (A или B).

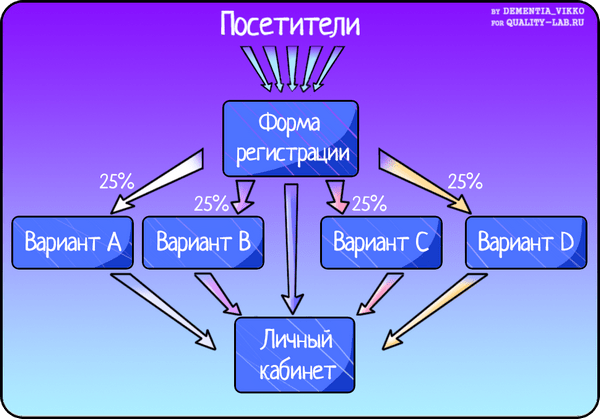

Проще говоря, весь поток людей на сайте разбивается на две группы. Одной группе отображается главная страница, к примеру, с кнопкой Sign up (Вариант А). Второй группе – та же страница, но с кнопкой Sign up for free (Вариант В). Тестирование проводится сессионно. В конце каждой сессии подводится итог и вычисляется вариант-победитель. Пример же многовариантного A/B тестирования приведен на схеме:

Как тестировать?

Представим себе ситуацию: онлайн-банку нужно было увеличить количество заявок на кредитование физических лиц. На сайте уже существовал баннер с призывом заполнить заявку, но маркетологи предложили его доработать. В отдел тестирования были переданы два макета для проведения A/B тестирования:

Прежде всего, в отделе тестирования определились с инструментами, позволяющими зафиксировать статистику и проанализировать результат. В сети можно найти с десяток платформ для проведения A/B тестирования, среди которых наиболее популярны следующие:

Все они по-своему удобны и содержат достаточное количество функций для того, чтобы стать незаменимым помощником при проведении А/В тестирования. Выбор наших тестировщиков пал на бесплатный Google Content Experiment (данное решение входит в состав Google Analytics и умеет самостоятельно определять победителя).

С помощью данной платформы был создан эксперимент для тестирования на сайте банка. Для получения корректных результатов необходимо было провести несколько сессий тестирования длительностью в две недели. В первую сессию тестировщики получили неоднозначный результат (конверсия в двух вариантах была почти равна, поэтому определить победителя A/B тестирования не удалось). После серии подобных экспериментов, тестировщикам все-таки удалось получить четкий результат тестирования: победил второй вариант баннера (с фотографией семьи). Возможно, это было связано с тем, что последняя сессия пришлась на новогодние каникулы: ЦА была лояльнее и дружелюбнее.

Итог истории: если раньше заявку на кредит подавали 2 из 10 просмотревших баннер, то теперь – 4 из 10.

Возвратимся к инструментам A/B тестирования. Для инструментов, которые не умеют определять победителя, итоги сессии А/В тестирования можно обработать вручную или при помощи калькулятора. При ручной обработке необходимо учесть соотношение конверсии к числу посещений сайта. Это трудоемкий процесс, который потребует от вас сосредоточенности и точности; он может затянуться на несколько часов. Намного удобнее воспользоваться готовым решением – калькулятором: вам достаточно будет ввести результаты тестирования и получить вариант-победитель. Почти все калькуляторы для A/B тестирования англоязычные, но есть и

Дмитрий Дементий

![]()

Как известно, в бизнесе не бывает статичных состояний. Предприятие должно постоянно развиваться, чтобы соответствовать текущей рыночной ситуации, потребностям клиентов и собственников. Остановив развитие, проект в ту же секунду начинает деградировать. Например, нельзя создать интернет-магазин, добавить на сайт 200 товаров и ежемесячно получать прибыль в сумме 100 тыс. рублей. Чтобы прибыльность проекта хотя бы не падала, предпринимателю необходимо постоянно расширять ассортимент, увеличивать охват аудитории с помощью рекламы и публикации полезного контента, улучшать поведенческие метрики сайта и коэффициент конверсии.

Одним из инструментов развития веб-проектов является A/B-тестирование. Этот метод позволяет измерять предпочтения аудитории и влиять на ключевые показатели эффективности сайта, включая конверсии, время пребывания пользователей на странице, среднюю сумму заказа, показатель отказов и другие метрики. Из этой статьи вы узнаете, как правильно проводить A/B-тестирование.

Что такое A/B-тестирование

A/B-тестирование — это маркетинговый метод, использующийся для оценки и управления эффективностью веб-страницы. Этот метод также называется сплит-тестированием (от англ. split testing - раздельное тестирование).

A/B-тестирование позволяет оценивать количественные показатели работы двух вариантов веб-страницы, а также сравнивать их между собой. Также сплит-тестирование помогает оценивать эффективность изменений страницы, например, добавления новых элементов дизайна или призывов к действию . Практический смысл использования этого метода заключается в поиске и внедрении компонентов страницы, увеличивающих ее результативность. Обратите внимание еще раз, A/B-тестирование - это прикладной маркетинговый метод, с помощью которого можно влиять на конверсию, стимулировать сбыт и повышать прибыльность веб-проекта.

Сплит-тестирование начинается с оценки метрик существующей веб-страницы (A, контрольная страница) и поиска способов ее улучшения. Например, вы создали интернет-магазин . Представьте себе посадочную страницу этого магазина с коэффициентом конверсии 2%. Маркетолог желает увеличить этот показатель до 4%, поэтому планирует изменения, которые помогут решить эту задачу.

Допустим, специалист предполагает, что изменив цвет конверсионной кнопки с нейтрального голубого на агрессивный красный, он сделает ее более заметной. Чтобы проверить, приведет ли это к увеличению продаж и росту конверсии, маркетолог создает усовершенствованный вариант веб-страницы (B, новая страница).

С помощью инструментов для проведения сплит-тестирования эксперт в случайном порядке разделяет трафик между страницами A и B на две приблизительно равные части. Условно говоря, половина посетителей попадает на страницу A, а вторая половина на страницу B. При этом маркетолог держит в уме источники трафика. Чтобы обеспечить валидность и объективность тестирования, необходимо направить на страницы A и B по 50% посетителей, пришедших на сайт из социальных сетей, естественного поиска, контекстной рекламы и т.п.

Собрав достаточно информации, маркетолог оценивает результаты тестирования. Как сказано выше, коэффициент конверсии страницы A составляет 2%. Если на странице B этот показатель составил 2,5%, значит изменение конверсионной кнопки с голубого на красный цвет действительно увеличило эффективность лэндинга. Однако показатель конверсии не достиг желаемых 4%. Поэтому маркетолог дальше ищет способы совершенствования страницы с помощью A/B-тестирования. При этом в качестве контрольной выступит уже страница с красной конверсионной кнопкой.

Что тестировать

Как отмечалось выше, сплит-тестирование - это прикладной метод, позволяющий влиять на различные метрики сайта. Поэтому выбор объекта тестирования зависит от цели и задач, которые ставит перед собой маркетолог.

Например, если показатель отказов посадочной страницы составляет 99%, при этом большинство посетителей покидает лэндинг в течение 2-3 секунд после «приземления», стоит задуматься об изменении визуальных компонентов страницы. С помощью A/B-теста маркетолог может найти оптимальный вариант макета страницы, выбрать привлекательную цветовую гамму и изображения, использовать читабельный шрифт. А если перед маркетологом стоит задача увеличить количество подписок, он может попробовать изменить соответствующую конверсионную форму. Сплит-тест поможет специалисту выбрать оптимальный цвет кнопки, лучший вариант текста, количество полей в форме подписки или ее расположение.

Чаще всего маркетологи тестируют следующие элементы веб-страниц:

- Текст и внешний вид конверсионных кнопок, а также их расположение.

- Заголовок и описание продукта.

- Размеры, внешний вид и расположение конверсионных форм.

- Макет и дизайн страницы.

- Цену товара и другие элементы бизнес-предложения.

- Изображения товаров и другие иллюстрации.

- Количество текста на странице.

Какие инструменты сплит-тестирования использовать

Чтобы выполнить A/B-тестирование, маркетологу необходимо воспользоваться одним из специализированных сервисов. Наиболее востребованным из них является Content Experiments компании Google, доступный пользователям системы Analytics. До середины 2012 года этот инструмент назывался Google Website Optimizer. С его помощью можно протестировать различные элементы страницы, включая заголовки, шрифты, конверсионные кнопки и формы, изображения и т.п. Сервис Content Experiments остается бесплатным, что относится к его основным преимуществам. К его недостаткам относится необходимость работы с HTML-кодом.

Также вы можете использовать для проведения сплит-тестирования следующие российские и иностранные инструменты:

- Optimizely - наиболее популярный в буржунете платный сервис A/B-тестирования. Стоимость его использования составляет от 19 до 399 долларов США в зависимости от типа подписки. К преимуществам данного сервиса относится возможность создания экспериментов в визуальном интерфейсе, что избавляет маркетолога от необходимости работать с HTML-кодом тестируемых страниц.

- RealRoi.ru - еще один отечественный сервис, который позволяет проводить А/Б-тестирование. Среди главных плюсов можно выделить то, что он бесплатен и очень прост в использовании. О том, как он работает, можно подробно посмотреть на следующем видео:

- Visual Website Optimizer - платный сервис, позволяющий тестировать различные элементы страницы. Чтобы использовать этот инструмент, маркетологу необходимо иметь навыки работы с HTML-кодом. Стоимость подписки составляет от 49 до 249 долларов.

- Unbounce - сервис, предназначенный для создания и оптимизации лэндингов. В том числе, он позволяет выполнять A/B-тестирование. Стоимость использования составляет от 50 до 500 долларов в месяц. Отечественный аналог - LPGenerator. Этот сервис позволяет тестировать только созданные с его помощью страницы.

Как провести A/B-тестирование с помощью Content Experiments

Сервис «Эксперименты» Google Analytics позволяет одновременно проверить эффективность пяти вариантов страницы. Используя его, маркетологи могут выполнять A/B/N-тестирования, отличающиеся от стандартных A/B-экспериментов возможностью следить за эффективностью нескольких новых страниц, каждая из которых может иметь несколько новых элементов.

Маркетолог имеет возможность самостоятельно определять долю трафика, участвующего в тестировании. Минимальная продолжительность теста составляет две недели, максимальная ограничена тремя месяцами. Специалист может получать данные о результатах тестирования на электронную почту.

Чтобы провести сплит-тестирование с помощью Content Experiments, выполняйте следующие действия:

- Войдите в аккаунт Google Analytics, выберите сайт, эффективность которого необходимо проверить. После этого выберите меню «Поведение - эксперименты».

- Введите в соответствующую форму URL страницы, которую вы будете тестировать, и нажмите кнопку «Начать эксперимент».

- Выберите название и цель тестирования. Определите процент трафика, участвующий в эксперименте. Решите, хотите ли вы получать оповещения о ходе тестирования на электронную почту. Нажмите кнопку «Далее» после выбора необходимых параметров.

- Выберите варианты страницы, участвующие в тестировании. Добавьте их в соответствующие формы и нажмите «Далее».

- Создайте код эксперимента. Если вы не знаете, как вставить его на страницу, выберите вариант «Отправить код веб-мастеру». Если вас не бросает в пот при упоминании HTML-кода, выберите вариант «Вставить код вручную».

Выбирайте «Вставить код вручную», если умеете обращаться с HTML-кодом

- Скопируйте отмеченный на предыдущей иллюстрации код и вставьте его в исходный код контрольной страницы. Код должен быть вставлен непосредственно после тега . После выполнения этого действия нажмите кнопку «Сохранить изменения».

- Проверьте наличие кода тестирования на контрольной странице и нажмите кнопку «Начать эксперимент». Обратите внимание, код необходимо добавить только на контрольную страницу.

Вы сможете оценить первые результаты тестирования через несколько суток после начала эксперимента. Чтобы следить за результатами тестирования, выберите соответствующий эксперимент в списке и перейдите на страницу отчетов.

Идеи, эффективность которых стоит обязательно проверить с помощью сплит-тестирования

Выше неоднократно отмечалось, что A/B-тестирование помогает увеличить эффективность веб-страниц. Чтобы этот маркетинговый метод принес результат, маркетолог должен генерировать идеи, способные позитивно влиять на те или иные метрики сайта. Нельзя просто брать какие-либо изменения с потолка, внедрять их и тестировать эффективность. Например, вряд ли метрики сайта изменятся, если вы просто решите изменить фон страницы с голубого на салатовый.

Маркетолог должен видеть способы улучшения страниц и понимать, почему они должны сработать. Cплит-тестирование просто помогает проверить предположения специалиста. Однако каждый маркетолог иногда оказывается в ситуации, когда все идеи проверены, а необходимого результата достичь не удалось. Если вы попали в такую ситуацию, попробуйте внедрить следующие изменения и проверить их эффективность:

- Удалите лишние поля из конверсионной формы. Возможно, ваши потенциальные подписчики не хотят раскрывать свои паспортные данные.

- Добавьте на конверсионную страницу слова «бесплатно» или free. Конечно, аудитория знает, что подписка на рассылку является бесплатной. Но иногда слово free творит настоящие чудеса, ведь дармовой уксус сладок.

- Опубликуйте на посадочной странице видео. Обычно это позитивно влияет на ряд метрик, включая показатель отказов, коэффициент конверсии и время пребывания на странице.

- Увеличьте срок, в течение которого пользователи могут бесплатно тестировать ваш продукт. Это простой и эффективный способ увеличения конверсий для компаний, продающих ПО и веб-сервисы.

- Экспериментируйте с цветом конверсионных кнопок. В некоторых случаях хорошо работают кнопки агрессивного красного цвета. Однако иногда они раздражают пользователей. Используйте A/B-тест, чтобы найти наиболее эффективный цвет кнопки для вашего сайта.

- Пообещайте бонусы первым 10 или 100 покупателям (подписчикам). Не спешите удалять это обещание даже после завершения акции. Многие пользователи не рассчитывают войти в число счастливчиков, однако все равно подсознательно реагируют на выгодное предложение.

Как и зачем тестировать разные варианты страниц

Сплит-тестирование позволяет оценить эффективность изменений веб-страниц. Этот маркетинговый метод имеет прикладное значение. Он позволяет практически постоянно совершенствовать страницы, улучшая различные метрики.

Чтобы протестировать то или иное изменение, необходимо создать новый вариант страницы и сохранить старый. Оба варианта должны иметь разные URL. После этого следует воспользоваться одним из сервисов для проведения сплит-тестов, например, Content Experiments. Оценку результатов тестирования можно проводить как минимум через две недели после запуска эксперимента.

Как вы считаете, стоит ли проводить A/B-тесты? В каких случаях этот маркетинговый метод остается бесполезной тратой времени?

kak-provodit-a-b-testirovanieО том, как с помощью A/B-тестирования выясняем, какая реклама работает лучше всего. В процессе выбора лучшей площадки для проведения экспериментов, мы протестировали и составили подборку сервисов для проведения тестирования. С полезными комментариями. И делимся с вами!

Какой функционал был для нас важен?

- Возможность бесплатно потестить сервис в полную силу. То есть на реальной рекламной кампании с большими потоками посетителей.

- Возможность подгрузки своего варианта страницы. Это означает, что мы хотим создать свою красивую страничку и загрузить ее в сервис, там же сделать изменения в онлайн-редакторе и запустить тест.

- Удобный и неглючный онлайн-редактор страниц.

- Правильное подцепление целей тестирования. Несложные цели можно настраивать прямо в сервисах. Собственно, по ним и по промежуточным целям можно сравнивать конверсии вариантов и выбирать выигрышный.

Как разобраться в подборке?

- Сервис — адрес сервиса, тут все просто.

- A/ B или MVT — какой из вариантов тестирования поддерживает сервис.

- A/ B-тестирование — это когда варианты тестируемой страницы отличаются одной переменной(разная кнопка, разный заголовок и т.д.). . Например, в одном варианте кнопка «Заказать» красная, в другом — зеленая. А в целом страницы идентичны.

- MVT — это многовариантное тестирование. Когда варианты тестируемой страницы отличаются в множестве разных вещей. Первый вариант синего цвета, с красной кнопкой «Заказать» и рисунком из бабочек в шапке страницы. Второй вариант — фиолетовый, с зеленой кнопкой «Заказать» и рисунком из единорогов. Третий вариант — вообще черно-белый, с мигающей кнопкой «Заказать» и фотографией заказчика на заднем фоне.

Некоторые сервисы лэндингов поддерживают функцию только A/ B-тестирования, некоторые и A/ B, и MVT.

- Тарифные планы — сколько денег хочет сервис за свои услуги. По каким параметрам определяется крутость тарифного плана?

- Количество посетителей, которое может перейти на страницу (если посетителей больше, чем разрешает тарифный план, эксперимент отключается).

- Количество доменов, на которых размещаются лэндинги.

- Количество самих экспериментов, которые можно запустить в сервисе.

- Количество аккаунтов, которое можно создать на сервисе.

В разные тарифы входят разные параметры, тут уж какой сервис на что горазд.

- Шаблоны\онлайн-редактор - Где-то есть готовые шаблоны, где-то есть редактор, с помощью которого можно изменять переменные.

- Демоверсия — сколько дней можно пользоваться этим сервисом бесплатно.

- Комментарии — наши личные замечания о работе каждого сервиса.

Подборка сервисов для A/B-тестирования

Русскоязычные сервисы

Сервис #1

- Сервис: http://abtest.ru/

- Поддержка тестирования: А/B

- Тарифные планы: тестирование бесплатно, сервис умирает и находится в бета-версии.

- Шаблоны\ редактор: онлайн-редактор.

- Комментарии: Разрешает подгружать свои лэндинги. Ужасно глючный редактор.

Сервис #2

- Сервис: http://lpgenerator.ru/

- Поддержка тестирования: A/B.

- Тарифные планы:

- $37 , 3500 посетителей, 2 домена, 25 страниц.

- $58 , 9000 посетителей, 5 доменов, 50 страниц.

- $119 , трафик, кол-во доменов и кол-во страниц не ограничено, подключение собственных доменов.

- $440 , трафик, количество доменов и страниц не ограничено, подключение собственных доменов, 15 клиентских аккаунтов, персональный брендинг.

- Шаблоны\редактор: шаблоны и онлайн-редактор.

- Демоверсия: 14 дней.

- Комментарии: Есть свой набор шаблонов и платных и бесплатных. Не нашлось инструмента загрузки собственных сайтов для изменения в редакторе. Редактор простой, но требует время для изучения.

Англоязычные сервисы

Сервис #3

- Сервис: http://unbounce.com/

- Поддержка тестирования: A/B.

- Тарифные планы:

- $49 — 5 000 посетителей.

- $99 — 25 000 посетителей.

- $199 — 200 000 посетителей

На всех планах: неограниченное количество тестов и страниц во всех планах, статистика, онлайн-конструктор страниц.

- Шаблоны\редактор: шаблоны и онлайн-конструктор(!).

- Демоверсия: 30 дней.

- Комментарии: Редактор довольно удобный и приятный в использовании. Не нашли, как загрузить свою страницу для изменения. Шаблоны страниц тусклые и неинтересные. В сервисе есть не просто онлайн-редактор блоков, а полноценный онлайн-конструктр, с помощью которого можно создать простой сайт с нуля.

Сервис #4

- Сервис: https://vwo.com/

- Поддержка тестирован ия: A/B, MVT и тестирование мобильных приложений.

- Тарифные планы:

- $49 , 10 000 посетителей.

- $129 , 30 000 посетителей.

- Индивидуальный тарифный план — около миллиона посетителей в месяц, тестирование на мобильных, связанные аккаунты, личный консультант.

- Шаблоны\ редактор: онлайн-редактор.

- Демоверсия: 14 дней.

- Комментарии: у сервиса красивый интерфейс, но при подгрузке своей страницы возникают проблемы.

Сервис #5

- Сервис: http://www.convert.com/ .

- Поддержка тестирования: A/B & MVT

- Тарифные планы:

- $9 , 2000 посетителей.

- $29 , 10 000 посетителей, MVT.

- $59 , 30 000 посетителей, MVT.

- $99 , 50 000 посетителей, MVT + тестирование мобильных сайтов.

- $139-$1499 , тарифные планы для агентств. Безлимитное количество проектов и тестов, онлайн-поддержка, интеграция с Google-Analytics.

- Шаблоны\ редактор: онлайн-редактор.

- Демоверсия: 15 дней.

- Комментарии: Удобный редактор своих страниц. Шаблонов нет. Все красиво, сочно и удобно, но периодически перестает считать цели, выявлялись ошибки/косяки сервиса, исправлялись техподдержкой, но на следующий день подцепление целей опять слетало по неизвестной причине.

Сервис #6

- Сервис: http://www.clickthroo.com/

- Поддержка тестирования: A/B.

- Тарифные планы:

- $195 , 50 000 посетителей, 5 проектов.

- $395 , 100 000 посетителей, 10 проектов.

- $695 , 100 000 посетителей, безлимитное количество проектов.

- $1195 , 250 000 посетителей, безлимитное количество проектов.

- Шаблоны\ редактор: шаблоны и онлайн-редактор.

- Демо-версия: 14 дней демодоступа.

- Комментарии: Делаешь запрос на демодоступ, заполняя огромную форму и не получаешь его. Ок, получаешь, но через пару рабочих дней.

Сервис #7

$1295

— до 10 000 посетителей в месяц. Неограниченное количество проектов, страниц, тестов, доменов, техподдержка.

$1295

— до 10 000 посетителей в месяц. Неограниченное количество проектов, страниц, тестов, доменов, техподдержка.

Чем Бухсофт Онлайн лучше обычной бухгалтерской программы!

Чем Бухсофт Онлайн лучше обычной бухгалтерской программы! Какой год является високосным и как его рассчитать

Какой год является високосным и как его рассчитать Молитва для зажигания лампады дома

Молитва для зажигания лампады дома В чем же была их сила и в чем слабость

В чем же была их сила и в чем слабость